안녕하세요, Infra Tech팀 조대열, Cloud AX전환1팀 김성겸, Cloud엔지니어링팀 이채흔입니다!

2025년, AI와 데이터 기반 서비스는 그야말로 황금기를 맞이하고 있습니다. 하지만 이 모든 흐름 뒤에는 커다란 전제가 하나 있습니다. 바로 “신뢰”입니다. AI는 높은 성능을 위해 더 많은 데이터를 요구하고, 그에 발 맞추어 민감한 데이터가 쏟아지고 있습니다. 이 상황에서 우리는 어떻게 민감한 데이터를 자유롭게 활용하면서도, 신뢰할 수 있도록 보호할 수 있을까요? 지난 6월, 샌프란시스코에서 열린 Confidential Computing Summit 2025은 이 모순적인 질문에 대한 답을 찾고자 하는 사람들이 모이는 자리였습니다. 컨퍼런스 현장에서 직접 담아온, AI와 보안이 교차하는 최신 기술 트렌드에 대해 공유드리고, 우리 KT의 관점에서 그것들이 왜 중요한지에 대해서도 풀어내보려고 합니다.

1. Confidential Computing Summit 2025

컨퍼런스 주요 목적:

-

Confidential Computing / AI 및 보안 Worklow에 대한 전략 공유

-

Confidential Computing 의 규제 산업에서의 실제 적용 사례 공유

등장 주요 기업 및 발표자:

-

KT : 주석훈 담당님 (IT Dev본부 Cloud AX기술담당)

-

Microsoft : Mark Russinovich (Chief Technology Officer and Technical Fellow for Microsoft Azure)

-

Google : Nelly Porter (Director of Product Management, GCP Confidential Computing and Encryption at Google)

-

Intel : Michael Reed (Senior Director, Confidential Computing at Intel)

-

Mozilla : Graham Mudd (Senior Vice President, Product Management at Mozilla)

2. 인상 깊었던 세션

2-1. “Confidential AI Agents in Action: Unlocking Powerful Automation Without Compromise”

- 발표자: Chester Leung (Co-Founder, Head of AI Platform, OPAQUE)

바야흐로 AI Agent 시대입니다. 이제 AI는 단순한 “챗봇”을 넘어 Agent(목표 기반 작업 수행자)로서 기업 전체 플로우를 조율할 수 있는 수준으로 발전하고 있습니다. AI Agent가 점점 더 자율성을 갖고 기업 시스템에 접근하게 되면서, 새로운 리스크들도 함께 등장했습니다. 민감 데이터는 점점 더 많이 노출되고 있고, 그에 따라 규제 위반 가능성도 높아졌습니다. 이런 와중에, 기존의 수동 감사 방식은 이 리스크들을 다루기에는 복잡하고 비효율적입니다.

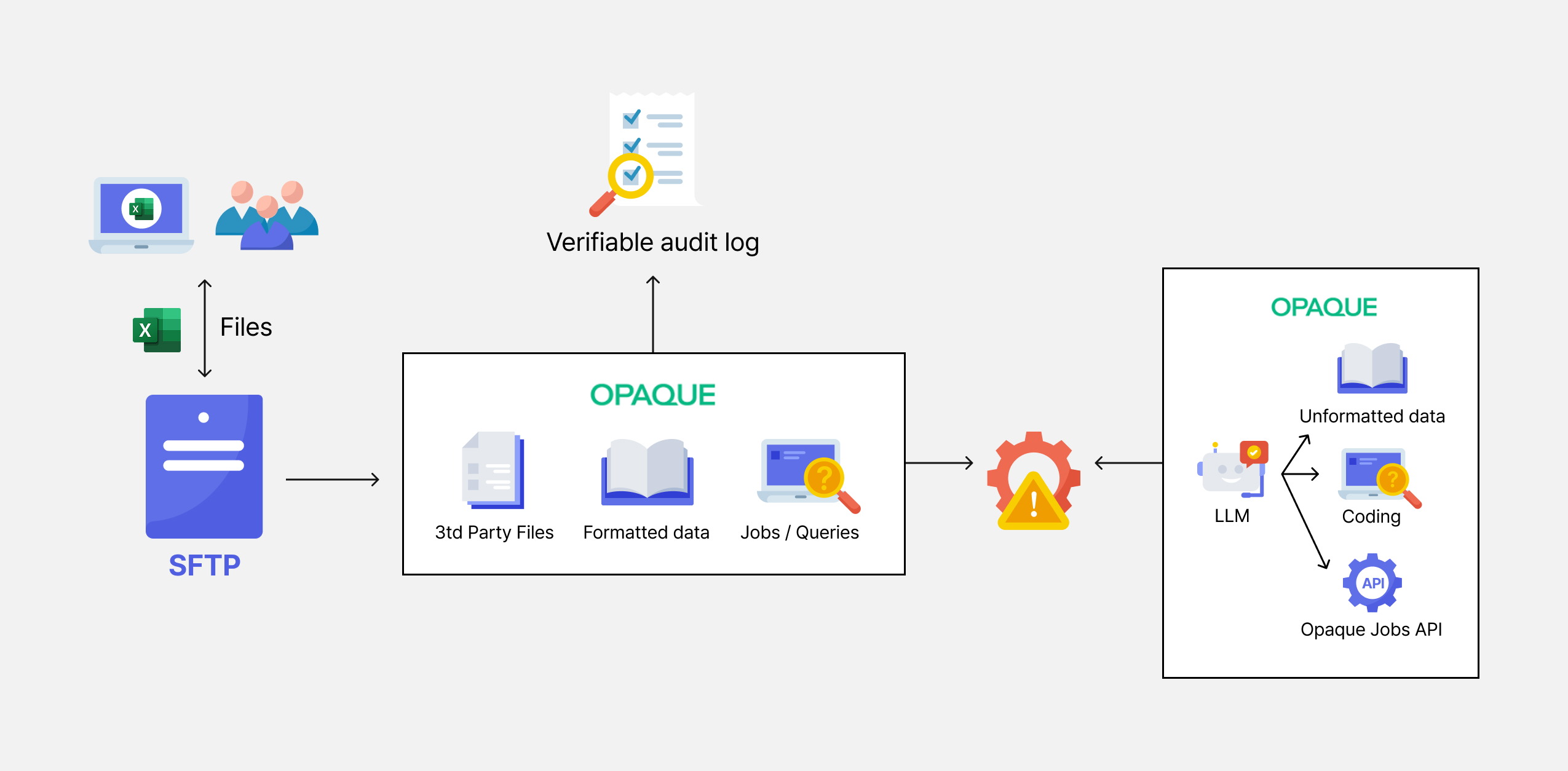

이러한 상황을 해결하기 위해, 금번 Summit의 가장 큰 스폰서이기도 한 OPAQUE 사에서는 Confidential AI Platform을 제안했습니다. 이 플랫폼에서는 모든 Agent의 동작이 하드웨어 기반 TEE(Truested Execution Environment) 단계에서 수행됩니다. TEE (Trusted Execution Environment) 란, 하드웨어 레벨에서 암호화에 의해 격리된 메모리 & CPU 영역입니다. 이 영역 외의 다른 코드는 이 격리된 영역에 있는 데이터를 읽거나 조작할 수 없습니다. 따라서 이 영역의 메모리에서 작업 중(In-use)인 데이터에 대해, Host OS, 하이퍼바이저에서 접근하지 못합니다. 또한 실시간 정책을 통해 허가된 쿼리/모델만 실행할 수 있도록 강제하며, Agent의 의사결정 등의 작업에 대해 암호학적으로 검증 가능한 감사 로그가 생성됩니다. 그리고 Workflow 과정 중 비정상적인 상황 발생 시, 플랫폼 내의 LLM 기반 Agent가 비정형 데이터 정제 및 코딩 자동화까지 처리하기 때문에, 완전 자동화를 달성할 수 있습니다. 결과적으로, 민감한 데이터 활용 시에도 안전한 Agent를 해당 플랫폼에 신속하게 배포할 수 있습니다.

- Insight

KT에서도 여러 AI Agent들이 개발 및 활용되고 있습니다. 특히 민감한 고객 정보나 내부 운영 데이터를 다루는 경우, 단순한 기능 구현을 넘어 데이터 보호와 규제 준수를 동시에 만족시킬 수 있는 구조가 필요합니다. OPAQUE가 제시한 방식처럼, 암호화된 상태에서 데이터를 처리하고, 정책 기반으로 Agent의 행동을 통제하며, 자동 감사 로그를 생성하는 구조는 KT의 AI Agent 운영에도 참고 모델이 될 수 있을 것이라고 생각됩니다. 특히 AI 도입 속도는 높이되, 리스크는 낮춰야 하는 요구사항이 있는 경우에 더욱 그렇습니다. 현재 Azure의 Marketplace에서도 OPAQUE의 Confidential AI Platform이 사용 가능하므로, PoC를 거쳐 해당 솔루션의 도입을 고려해볼 수도 있을 것으로 보입니다.

2-2. “Trustless Attestation Verification in Distributed Confidential Computing”

- 발표자: Donghang Lu (TikTok Inc.)

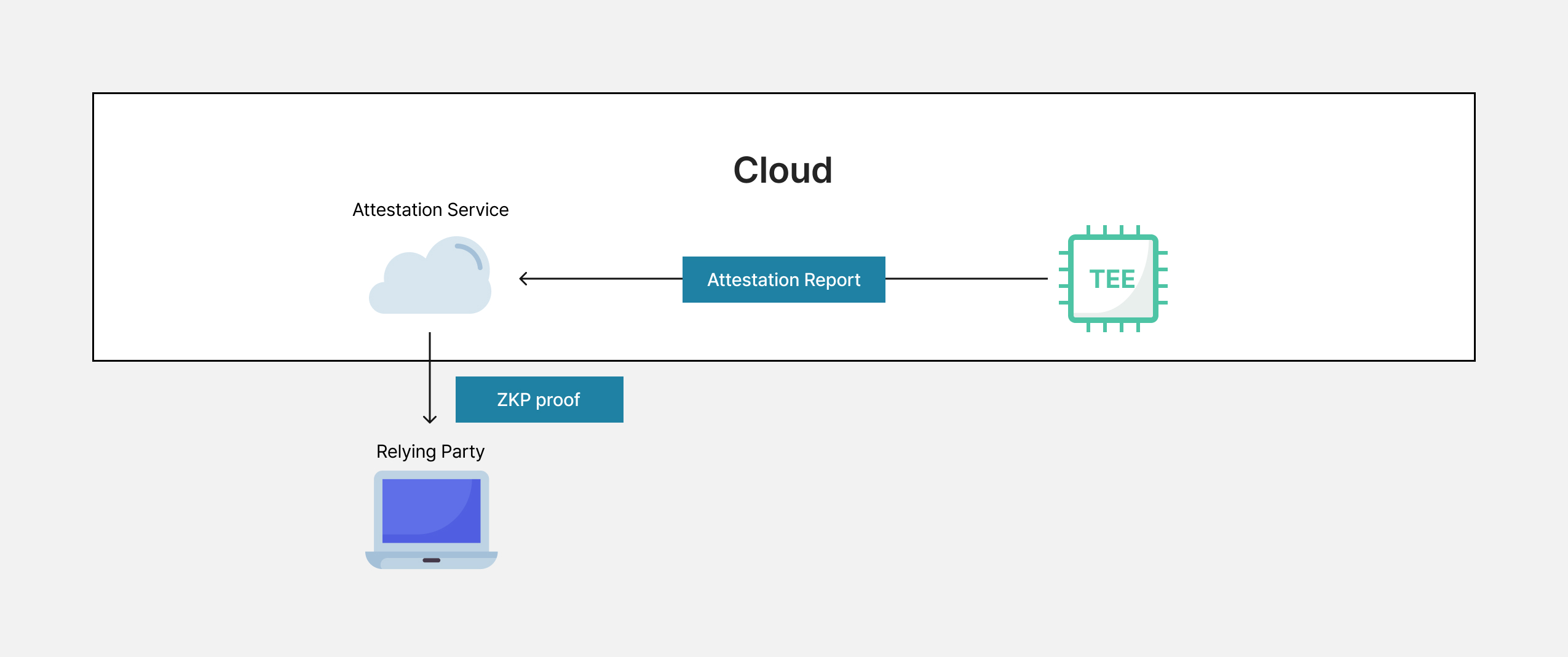

Confidential Computing 기술을 사용하는 클라이언트는 민감한 데이터를 TEE(Trusted Execution Environment)로 보내기 전에, TEE가 실제로 신뢰 가능한 환경인지 여부를 확인해야 합니다. 이를 위해 TEE는 하드웨어의 벤더사 및 펌웨어 버전 정보 등을 이용해서 생성한 Evidence를, 클라우드에서 제공하는 중앙화된 Attestation 서비스에 보내 검증을 요청하는 것이 일반적입니다. 하지만 만약 해당 Attestation 서비스가 오작동하거나, 외부에 의해 공격 받은 상황이라면 어떨까요? 이 경우에는 TEE 또한 신뢰하기 어렵습니다. 즉, 현재 일반적으로 사용되고 있는 Remote Attestation 방식에서는 TEE 뿐만 아니라 Attestation Service까지 신뢰 경계(TCB)가 넓어지는 문제가 존재합니다.

이를 해결하기 위해 TikTok 사에서는 ZKP(Zero-Knowledge Proof)를 활용한 Trustless Attestation 방식을 제안했습니다. ZKP란, 증명하고자 하는 쪽(Prover)에서 검증하는 쪽(Verifier)에게, 특정 진술(ex) “나는 한국인이다”)이 참이라는 것을, 기타 정보(ex) “여권 정보”)를 제공하지 않고 증명하는 방법입니다. ZKP를 사용한 방식에서는, Remote Attestation 서비스가 자신이 올바른 코드로 작동 중이라는 증거를 ZKP Proof로 증명하고, 클라이언트는 결과와 증명만 확인하면 되므로 클라우드 운영자를 신뢰할 필요가 없습니다. 특히 분산 환경에서 수천 개의 TEE 노드가 협력하는 구조에서는, 모든 노드의 Attestation을 분석하는 것은 성능/운영적으로 부담이 큽니다. 이 때, 여러 ZKP를 계층적으로 압축하는 Proof Aggregation 기술을 통해 단일 증명만으로 전체 신뢰를 확보할 수 있습니다. 이는 AI 모델이나 상용 알고리즘처럼 코드 보호와 컴플라이언스가 중요한 서비스에 매우 적합한 구조입니다.

- Insight

KT의 SPC(Secure Public Cloud) 환경에서 사용되는 Confidential Virtual Machine (CVM) 부팅 시에도, Guest VM 펌웨어 측정 값이 포함된 Report를 Azure Attestion에 보내 유효성을 검증받은 후, Managed-HSM에서 키를 릴리스하는 데 사용되는 증명 토큰을 발급받습니다. 이처럼 우리의 시스템이 일상적으로 Azure Attestion을 사용한다는 것을 인식하고 있었지만, 그 Workflow에 내포된 보안 측면에서의 모순을 평소에는 인식하지 못했습니다. KT SPC에서 Confidential Virtual Machine(CVM)과 Customer Managed Key(CMK)를 도입함으로써 보안 주권을 더욱 강화했던 것처럼, Remote Attestion 과정에 대해서도 비슷한 고민을 할 필요가 있겠다는 생각이 들었습니다. 이처럼 평소에 생각지 못했던 기술적 포인트에 대해 알게 되고 고민하게 되는 것이, 컨퍼런스에 참석함으로써 얻을 수 있는 가장 큰 효용 중 하나라고 생각됩니다.

2-3. "Confidential Containers for GPU Compute: Incorporating LLMs in a Lift-and-Shift Strategy for AI"

- 발표자: Zvonko Kaiser (Principal Systems Engineer at NVIDIA)

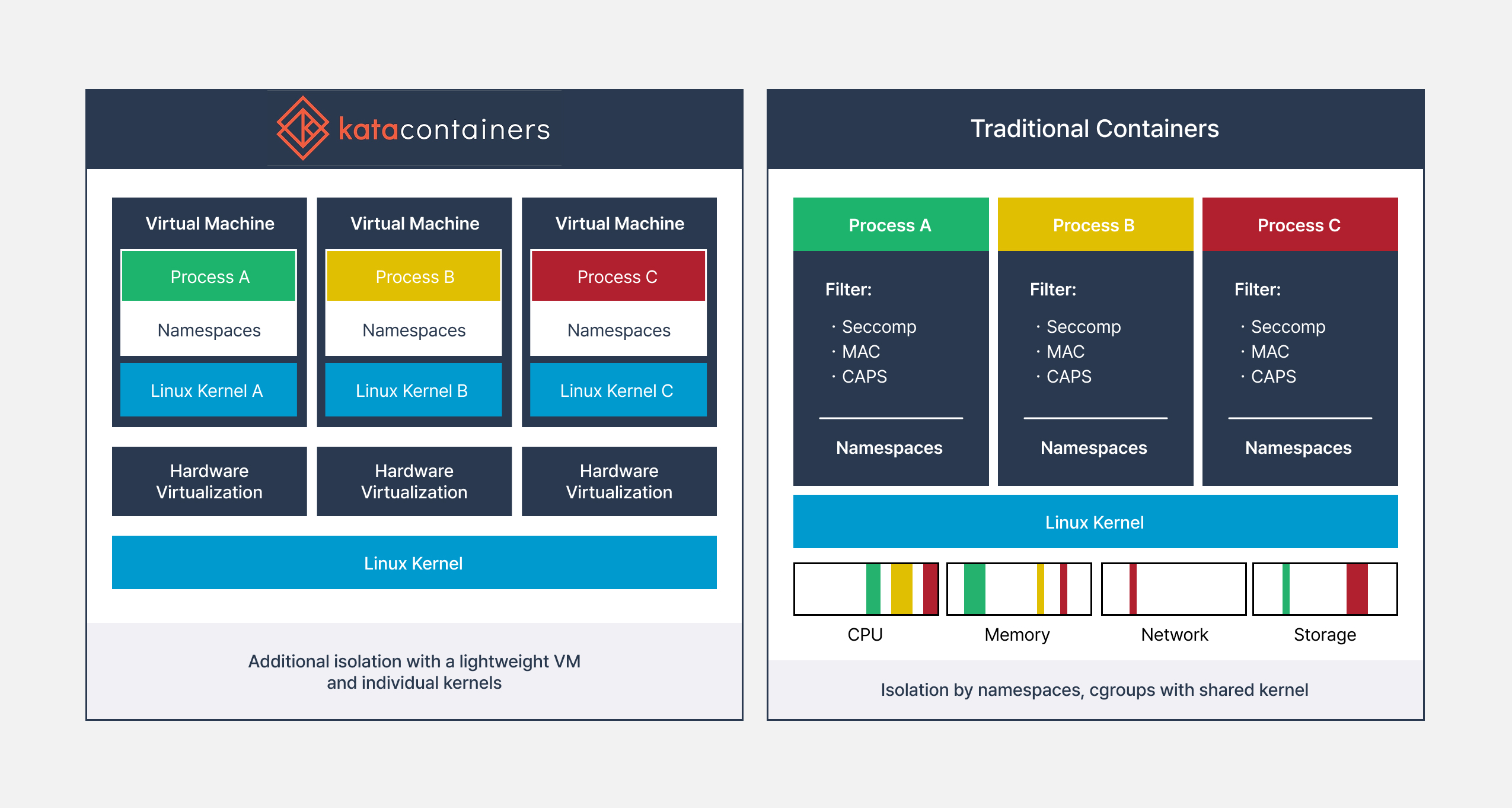

현대 AI 워크로드, 특히 LLM(대규모 언어 모델)은 GPU 리소스를 활용하는 컨테이너 환경에서 많이 구동됩니다. 하지만 전통적인 컨테이너 환경은 커널을 공유하기 때문에 호스트 OS와의 보안 경계가 약하고, 멀티 테넌트 환경에서 취약합니다. 이런 문제를 해결하기 위해 Kata Containers 기반의 Confidential Container가 소개되었습니다.

Kata Container는 하이퍼바이저를 활용해 Pod 안에서 가상 머신을 실행합니다. 즉, 겉보기에는 컨테이너처럼 보이지만 실제로는 Pod 내부에서 VM이 동작하는 구조입니다. 컨네이터와 VM의 장점을 결합하여 컨테이너의 속도와 유연성에 하드웨어 수준의 격리 보안을 결합하여 안전한 환경을 제공합니다. TEE(Trusted Execution Environment)와 결합한다면 Confidential Container 환경이 가능하게 되는 것입니다. GPU를 활용한 AI/ML 워크로드 환경에서도 Kata 아키텍처를 적용할 수 있습니다. 사용자는 Pod/컨테이너 단위로 runtime을 선택할 수 있어 use-case별로 GPU 정밀 제어가 가능합니다. GPU Operator라는 도구를 통해 GPU 관련 배포와 라이프사이클 관리가 가능합니다. Kata Container는 네임스페이스 독립성을 제공하고, OCI 호환성을 준수하여 기존 컨테이너 환경을 Lift-and-Shift 방식으로 손쉽게 옮겨올 수 있습니다.

- Insight

현재 KT에서는 Confidential VM을 적용하고 있지만 Confidential Container에 대해서는 고려하고 있지 않습니다. 하지만 위 세션에서 언급했듯이 컨테이너와 OS 사이의 보안 취약점이 존재한다는 점은 사실입니다. SPC의 과제는 VM 레벨의 암호화에 더해서 컨테이너 레벨의 암호화를 고려해야 한다고 생각합니다. Kata Container에서 제시한 컨테이너에 하이퍼바이저 가상화를 결합하는 환경은 어떻게 보면 컨테이너를 사용하는 이유 중 하나인 ‘경량성(Lightweight)’의 개념과 많이 멀어지는 것 같다는 생각이 들기도 합니다. 하지만 데이터 전 주기 암호화를 위해서 컨테이너 환경에서 한번 고려해볼만한 옵션 중 하나라고 생각됩니다.

2-4. “Enterprise Confidential Computing in Korea Telecom”

- 발표자 : 주석훈 담당님 (IT Dev본부 Cloud AX기술담당)

Confidential Computing Summit의 주된 목적 중 하나는 Confidential Computing 기술의 실제 적용 사례를 공유하는 것입니다. IT Dev본부 Cloud AX기술담당의 주석훈 담당님께서는 KT SPC 환경에서의 Confidential Computing 적용 사례에 대해 발표하셨습니다. 먼저 KT가 SPC 환경을 마련하게 된 이유로서, 데이터 유출 및 규제에 대응하고자 하는 목적과, Public 클라우드의 Agility를 활용하면서도 보안도 확보하고자 하는 목적 측면에서 설명하셨습니다. 그 다음 KT SPC의 아키텍처, Confidential Computing 적용 지점 및 특성 등에 대해 설명하신 후, Mass Migration 과정에서 다양한 섹터의 서비스들에 SPC를 적용한 사례에 대해 공유하셨습니다. 마지막으로는, KT SPC 서비스의 B2B 진출 등의 향후 로드맵에 대해 소개하시며 세션을 마무리하셨습니다.

Confidential Computing 기술은 효용은 분명하지만, 아직 성장 단계에 있기에 각 사의 적용 사례를 공유하는 것은 기술의 성숙을 위해 매우 중요한 일일 것입니다. 이러한 관점에서 주석훈 담당님의 KT사례 공유 또한, 기술 발전에 기여한 소중하고 의미있는 세션이었다고 생각됩니다.

3. 참관 후기

대열

컨퍼런스가 열리는 샌프란시스코 도심으로 향하면서, 큰 전광판들을 대부분 IT 회사의 광고들이 채운 것을 보고 느꼈던 신선한 감각이 기억 속에 남아있습니다. 그제서야 세계 IT의 중심지에 왔다는 것을 비로소 실감하게 되었던 것 같습니다. 컨퍼런스에서는 세션들이 동시다발적으로 열렸기 때문에 여러 강연장을 돌아다니며 발표를 들었습니다. 회사에서 Confidential Computing 기술이 적용된 Confidential Virtual Machine을 직접 배포해보기도 하고, 관련 내용을 담당 내에 공유하기도 했었습니다. 하지만 그러면서도 "왜 지금 이 시점에" Confidential Computing 기능이 대두되고 있는 지에 대해서 진지하게 고민해본 적은 없었습니다.

금번 컨퍼런스 참관을 통해 AI가 Agent로서 우리 업무 사이에 들어오는 지금의 상황과 Confidential Computing 기술을 연결 지어 생각해볼 수 있었습니다. 또한 Remote Attestation 프로세스를 보완하는 방법 및 Confidential Container와 같은 새로운 기술들을 접하면서, 앞으로 KT SPC가 나아가야 할 미래를 그려볼 수도 있었습니다. 돌이켜보면 기대했던 것보다 더 의미 있었던 참관이었고, 금번 참관에서 얻은 인사이트들을 기반으로 업무도 새롭게 바라볼 수 있게 된 것 같습니다.

성겸

이번 Confidential Computing Summit에서는 다양한 산업 도메인 및 기업에서 Confidential Computing 기술들을 적용하고 있는 것 뿐만 아니라, ROI 관점의 효과 검증에 대해서도 고민을 하는 것을 알 수 있었습니다. 많은 기업들이 보안성 향상의 필요성에 대해 공감은 하지만, 직접적인 비용 대비 효과를 정량적으로 측정하는데 어려움을 겪습니다. 다만 한 가지 분명한 것은 보안 이슈에 대해 ROI 회수 관점에서만 선택을 한다면 추후 더 큰 비용을 지불할 수도 있다는 것입니다. 따라서 비용과 보안성의 상충관계를 효과적으로 다루기 위해서는 Confidential Computing 기술의 사업 적용 범위에 대한 고민도 같이 필요하다고 생각합니다.

또한 많은 기업들이 금융, 헬스케어, 공공, 광고 등의 다양한 산업 도메인에서 여러 방식의 Confidential Computing 기술을 적용하고 있다는 것을 알 수 있었습니다. 우리 KT도 Azure 마이그레이션을 진행하면서 SPC(Secure Public Cloud) 환경에 Confidential Computing을 적용하고 있는데, 이를 바탕으로 다양한 산업에서 보안 요구사항에 선제적으로 대응할 수 있는 레퍼런스를 쌓는 것이 매우 중요하다고 느껴졌습니다.

마지막으로, 이번 Confidential Computing Summit를 통해 여러 기업에서 발표한 기술의 새로움에 대해 단순히 감탄하는 것을 넘어, KT의 서비스에 해당 기술을 어떻게 접목할 수 있을지, 그로 인해 고객에게 어떤 가치를 줄 수 있을지 고민하는 과정이 매우 의미 있었습니다. 앞으로도 이처럼 다양한 컨퍼런스 참여를 통해 업무에 대한 시야를 넓히고, 업무에 적용 가능한 인사이트를 계속 발굴해 나가고 싶습니다.

채흔

Confidential Computing Summit에 참관하게 되면서 가장 궁금했던 점은 Confidential Computing의 실제 서비스 적용 사례였습니다. KT SPC 랜딩존의 설계/구축하는 업무를 하면서 레퍼런스가 될 만한 사례가 많이 없기도 했고 처음 접해보는 기술이다 보니 글로벌에서 이 기술을 얼마나 사용하는지, 그리고 얼마나 관심을 받고 있는지가 궁금했습니다. 또한 PoC를 하면서 하나 하나 삽질했던 경험이 있다 보니 비슷한 경험을 하신 분들과 대화를 해 보고 싶기도 했습니다.

Summit에서는 생각보다 다양한 회사/학교들이 실제 서비스 사례들과 연구 과제들을 공유하였습니다. 저는 컨테이너 보안에 관심이 있어서 컨테이너 관련된 세션을 찾아 들었는데요, OS와 컨테이너 사이의 보안 취약점을 강화할 수 있는 여러 가지 Insight를 얻을 수 있었습니다. 적용 사례들을 소개하는데 그치지 않고 한계점과 보안적으로 더 고려해야 할 사항들을 솔직하게 이야기하는 분위기라서 더욱 유익했던 것 같습니다.

개인적으로 아쉬웠던 점은 세션 시간이 짧았다는 점입니다. 가장 짧은 세션은 10분 동안 진행되어서 내용을 파악하기가 조금 힘들었습니다. 그래도 KT에서 Confidential Computing을 적용한 사례를 발표할 수 있어서 자랑스러웠고 다음에 또 기회가 된다면 KT에서 Confidential Computing 기술을 PoC한 경험과 더욱 다양하고 많은 서비스 적용 사례를 공유하면 좋겠다는 생각이 들었습니다.