안녕하세요. 저희는 KT의 Gen AI Lab에서 AX(AI Transformation) 사업 특화 모델 개발을 담당하고 있는 서현태, 강민지입니다.

이번 글에서는 AI 기술을 사내·외 비즈니스 환경에 적용한 사례를 소개하고자 합니다. 저희는 공공기관 RAG 프로젝트에 KT의 믿:음 모델을 적용하였습니다. 고객의 특수한 요구사항을 충족하면서도 높은 실사용성을 보장하는 것은 AI 모델 개발자들이 직면하는 가장 중요한 도전 과제 중 하나입니다. 이 글을 통해 ① 도메인 별 특화 데이터 수집 및 학습 데이터 생성 전략, ② 단계별 모델 학습 설계 방법론, ③ 멀티태스크 환경에서의 성능 최적화 기법, ④ 실무 평가 및 검증 프로세스에 대해 종합적으로 다루면서, 실제 서비스 환경에서 AI 모델을 성공적으로 구현하기 위한 구체적인 방법론을 공유하고자 합니다.

믿:음 모델의 외부 사업 적용 사례: 공공기관 RAG 프로젝트를 통한 공공 특화 AI 개발

1. 사업 개요

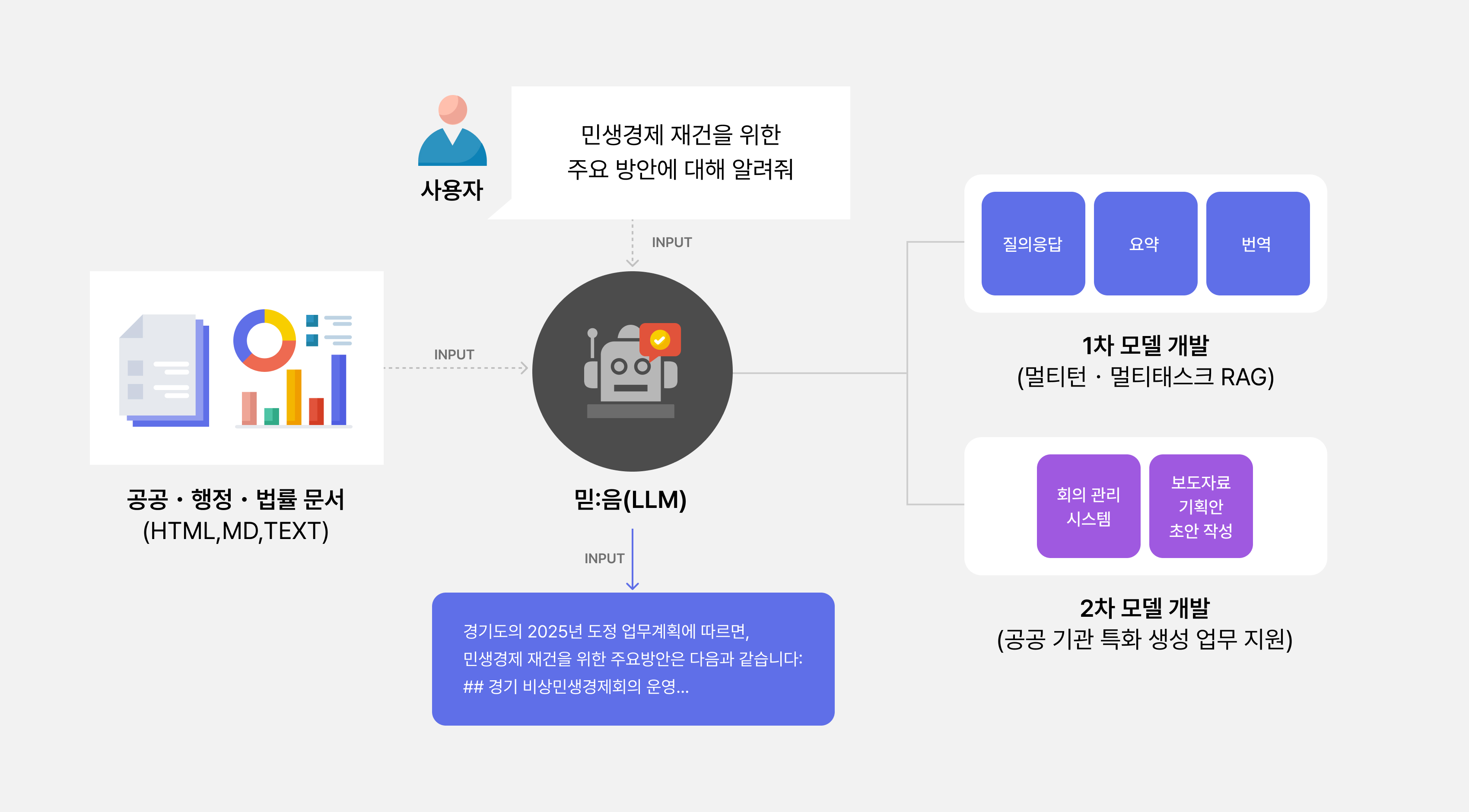

저희는 공공 문서를 기반으로 하는 대규모 RAG(Retrieval-Augmented Generation) 프로젝트를 수행하였습니다.

RAG는 대규모 언어 모델(Large Language Model, LLM)이 응답 생성 시에 외부 문서 내용 등을 함께 참고하도록 하여, 주어진 컨텍스트 또는 질문에 대해 보다 정확하고 풍부한 답변을 생성하도록 하는 기술입니다. 특수 도메인에 대한 RAG 기술을 확보하기 위해, 저희는 공공·행정·법률 도메인 문서 기반으로 다양한 목적의 RAG 태스크를 수행할 수 있는 KT 버티컬 AI 모델을 1, 2차에 걸쳐 개발하였습니다.

먼저, 1차에서는 공공·행정·법률 도메인에서 멀티턴(multi-turn) 질의응답, 요약, 번역 태스크에 대한 높은 성능을 달성하는 것을 목표로 하였습니다. 나아가 2차에서는 기본적인 RAG 능력에 더해, 회의 관리 시스템, 보도자료·기획안·안내문 작성과 같이 공공기관에서 수요가 높은 생성 업무까지 수행할 수 있도록 모델을 고도화하였습니다.

1.1. 1차: 공공·행정·법률 문서 기반 질의응답·요약·번역

1차 개발 단계에서의 태스크 별 상세 목표는 표 1과 같습니다. 특히 1차에서 중점적으로 고려한 것은, LLM이 사용자와 주고 받는 대화 맥락을 유지하고 이해하면서 여러 RAG 태스크에 대해 높은 성능을 낼 수 있도록 학습하는 것입니다. 사용자는 질의 대상이 되는 문서를 첨부한 후, 여러 턴에 걸쳐 다양한 작업을 요청할 수 있습니다.

예를 들어, 1) 성과보고서에서 특정 사업의 목표와 성과에 대해 정리하고(태스크: 요약) → 2) 해당 사업의 연도별 예산 증감률을 계산한 후(태스크: 질의응답-수학 계산) → 3) 지금까지 정리한 내용을 전문적인 영어로 번역해달라는 요청(태스크: 번역)을 할 수 있습니다. 이와 같이, 앞선 대화 내용을 기억하고 RAG 입력으로 활용해야 하는 일련의 흐름 속에서 LLM이 준수한 성능을 유지할 수 있도록 하였습니다.

| 태스트

|

태스크 목표

|

| [태스크 공통]

|

-

다양한 포맷(HTML, Markdown)의 문서 내용을 이해하고 활용

-

다양한 길이의 문서에 대해 강건한 RAG 성능 보유

-

답변 길이와 포맷, 말투 등 사용자의 다양한 지시 사항을 준수(instruction following)

-

앞선 대화 맥락에 대한 이해를 바탕으로, 사용자의 요청에 적절하게 응답

|

| 질의응답

|

-

주어진 문서 내용으로부터 필요한 정보를 찾고(retrieval), 질의 내용에 대해 체계적인 답변을 생성(generation)

-

단순 정보 검색은 물론, 추론 및 수학 계산이 필요한 질의에 대응

|

| 요약

|

|

| 번역

|

|

표 1. 1차 모델 개발 목표

1.2. 2차: 공공기관 내 수요가 높은 생성 업무 지원

2차 개발 단계에서는 회의 관리 시스템 및 보도자료·기획안·안내문 작성과 같은 공공기관 특화 태스크를 추가로 학습하였습니다. 주어진 문서를 기반으로 LLM이 회의록, 보도 자료, 기획안과 같은 공공 문서의 초안을 작성하고, 이후 사용자와 상호작용하면서 세부 내용, 스타일, 포맷 등에 대한 추가 요청을 할 수 있도록 모델을 학습하였습니다. 2차에서의 태스크 별 상세 목표는 표 2와 같습니다.

| 태스크

|

태스크 목표

|

| 회의 관리 시스템

|

|

| 보도자료·기획안·안내문자료 작성

|

-

참고자료 기반 보도자료·기획안·안내문 초안 작성

-

사용자와의 상호 작용을 통해 자료의 세부 내용, 스타일, 포맷 등에 대한 교정 지원

|

표 2. 2차 모델 개발 목표

2. 도메인 특화 데이터·문서 수집

효과적인 RAG 시스템을 구축하기 위한 출발점은 고품질 소스 데이터를 확보하는 것입니다. LLM이 특정 도메인의 질문에 대해 정확하고 신뢰할 수 있는 답변을 내놓기 위해서는, 우선 해당 도메인에 대한 충분한 지식 학습이 선행되어야 합니다. 따라서 이번 프로젝트에서는 공공기관으로부터 공식적으로 전달 받은 문서 뿐만 아니라, 이와 유사한 공공·행정·법률 도메인 문서를 다수 확보하는 것에 주안점을 두었습니다.

동시에, 모델이 학습하는 지식이 이들 도메인에만 치우치지 않도록, 학습에 활용할 수 있는 타 도메인 문서 또한 동시에 확보하고자 노력하였습니다. 모든 데이터는 사전에 라이선스 검토를 거쳐 적합성이 확인된 경우에 한해서만 실제 학습에 활용하여, 데이터 사용의 법적 안정성을 확보하였습니다. 소스 데이터 확보 방법 및 데이터 별 특징은 표 3 내용과 같습니다.

| 데이터셋

|

문서 포맷

|

원천 및 수집 방법

|

데이터 구성 및 특징

|

공공기관

공식 문서

|

PDF

|

|

-

내부 정책, 보도 자료, 복지 정책, 조례집, 업무 가이드라인 등

-

문서 내 줄글, 표, 통계 분석 자료(수치) 등을 다수 포함하는 복합 구조 문서

-

평균 100 페이지 이상으로 길이가 긴 문서

-

데이터 수량이 매우 제한적

|

| 정부 부처 온라인 공개 문서

|

PDF

|

-

인사혁신처, 고용노동부 등 정부 부처가 온라인 공개

-

웹 크롤링 및 파싱을 통해 자동 수집

-

라이선스 검토 후, 적합성이 확인된 문서에 한하여 사용

|

-

업무 지침, 보도자료, 시행규칙, 예산운용계획 등

-

도메인 적합성이 높으나, 공식 문서 대비 문서의 복잡성은 다소 부족

|

| 요약·번역 공개 데이터셋

|

JSON

|

|

-

기술과학, 법률, 교육, 금융 등 다양한 도메인의 요약, 번역 데이터

-

LLM의 일반적인 언어 능력 향상 및 도메인 편향 방지를 위한 데이터로 활용

|

| 한국어 RAG 벤치마크 데이터셋

|

PDF

|

|

-

금융, 공공, 의료, 법률, 커머스 도메인 문서

-

비교적 길이가 짧은 문서

|

표 3. 원천 데이터 확보 방법 및 데이터 특징

3. 학습 데이터셋 생성 전략

3.1. 소스 문서 가공

RAG 학습 데이터셋을 구성하는 첫 단계는 학습 입력으로 사용할 문서를 적절히 가공하고 조합하는 일입니다. 문서의 포맷, 길이, 복잡도, 그리고 문서와 사용자 질문 간의 관련성에 따라 모델의 RAG 성능이 크게 달라질 수 있습니다. 따라서 다양한 문서 입력 상황을 가정하고, 이에 맞게 문서를 조합하는 과정이 필요합니다. 이렇게 조합한 문서는 이후 단계에서 질문-답변쌍을 생성하기 위한 소스 데이터로 활용됩니다. 문서 포맷, 길이, 복잡도, 사용자 질문과의 관련성에 대한 세부 고려 사항은 표 4로 정리하였습니다.

| 구분

|

모델 성능 영향 요인

|

학습 데이터셋 가공시 고려 사항

|

| 문서 포맷

|

|

-

실 서비스 환경에서 사용 예정인 문서 변환 도구를 적용하여, PDF 파일을 구조적 정보(문단, 표, 리스트 등)가 최대한 보존된 텍스트 포맷으로 변환 필요(본 프로젝트에서는 KT 솔루션 DocuSee 사용)

-

학습 시 포맷 편향이 생기지 않도록 다양한 포맷을 균형 있게 포함

|

| 문서 길이

|

|

|

| 문서 복잡도(구조적 복잡성)

|

|

|

| 문서 복잡도(도메인 난이도)

|

|

-

도메인(행정, 법률, 의학 등) 특화 전문 용어·지식이 포함된 문서일수록 이해 난이도 상승

-

학습 데이터 내 타겟 도메인 문서를 충분히 포함하되, 특정 분야에 과도하게 편향되지 않도록 설계

|

| 문서 관련성

|

-

사용자 질문과의 관련성

-

Positive/Negative 문서 조합

|

-

Positive 문서(사용자 질의와 관련 있는 문서)만 주어질 경우 retrieval 난이도가 낮지만, 실제 환경에서는 Negative 문서(사용자 질의와 관련 없는 문서)가 함께 주어질 확률이 높음.

-

Negative 문서를 포함해야 불필요한 정보를 걸러내는 능력을 학습 가능

-

Positive와 Negative 문서 비율을 적절히 조정해 학습 데이터 구성

|

표 4. 소스 문서 가공 시 고려 사항

3.2. 태스크 별 싱글턴 데이터 생성

이번 단계에서는, 앞서 가공한 문서를 바탕으로 싱글턴 학습 데이터셋을 생성합니다. 우선, 프로젝트에서 목표로 하는 각 RAG 태스크를 세분화하여 학습 데이터의 다양성을 설계하는 작업이 필요합니다. 예를 들어, 문서 기반 질의응답 태스크만 하더라도 1) 줄글 내에서 필요한 정보를 찾는 질문, 2) 표에 대한 해석을 요구하는 질문, 3) 특정 주제에 대한 모델의 주관적 견해를 묻는 질문, 4) 계산이나 추론을 요구하는 복잡한 질문 등 여러 유형으로 나눌 수 있습니다.

이에 더해, 사용자가 요청할 수 있는 추가적인 Instruction Following(지시내용 준수) 능력에 대한 학습도 고려해야 합니다. 예를 들어, “100자 이내로 작성해줘.”, “JSON 포맷으로 출력하고, 부가적인 설명은 생성하지 마.”와 같은 요구사항은 실 사용 환경에서 매우 빈번하게 등장합니다. 따라서 이러한 요구를 데이터 생성 과정에 함께 반영하여 실사용성을 높일 수 있도록 합니다. 예상되는 사용자 수요에 맞게 세부 태스크 및 필요한 Instruction Following 유형을 정의하였다면, 앞서 가공한 문서를 활용해 질문-답변 합성 데이터 쌍을 생성합니다. 싱글턴 데이터 생성 흐름도는 그림 2와 같습니다.

그림 2. 싱글턴 데이터셋 생성 흐름도

3.3. 멀티턴 데이터로의 확장

다음으로는, 앞서 구축한 싱글턴 질문-답변 데이터셋 멀티턴 학습 데이터셋으로 확장하는 과정이 필요합니다. 실제 사용자와의 상호작용은 단일 질문-응답에 그치지 않고, 멀티턴 대화로 이어지는 경우가 대부분이기 때문입니다. 멀티턴 대화에서는 다양한 대화 패턴을 고려해야 합니다. 예를 들어, 사용자는 1) 앞선 대화 내역에 언급했던 내용에 대해 다시 질의하거나, 2) 동일한 주제에 대해 더 깊이 있는 질문을 이어가거나, 3) 전혀 새로운 주제에 대해 질의하는 등 다양한 패턴을 보일 수 있습니다.

또한 RAG 특화 태스크에서 나아가, LLM과의 잡담(chitchat)과 같은 간단한 상호작용까지 포함하여야 모델이 실제 환경에서 유연하게 대응할 수 있습니다. 멀티턴 데이터는 모델의 입력 길이 제한을 고려하여 N번의 turn에 걸친 Passage-Query-Response의 전체 길이가 32K 토큰을 초과하지 않도록 구성합니다. 멀티턴 데이터의 생성 흐름도는 그림 3과 같습니다.

그림 3. 멀티턴 데이터셋 생성 흐름도

4. 모델 학습 방법 및 결과

4.1. 1차 모델 학습: 공공·행정·법률 문서 기반 질의응답·요약·번역 학습

기학습된 범용 LLM을 특정 도메인에 최적화하는 과정에서 가장 중요한 과제는, 기존 능력의 보존과 새로운 전문성 습득 사이의 균형을 유지하는 것입니다. 이를 해결하기 위해 단계적(multi-stage) 학습 접근법이 효과적인 전략으로 주목받고 있습니다. 본 프로젝트에서는 믿:음 K 2.0 Base 모델을 기반으로, 그 위에 특화 RAG 능력을 추가하는 Stage-2 학습을 설계했습니다. 이 과정의 핵심 목표는 기존 모델의 일반적인 언어 능력을 유지하면서, 동시에 도메인 특화 성능을 극대화하는 것입니다.

특히 본 학습 과정에서는 메타 러닝(Meta-Learning) 이론에 기반한 가중치 설계를 적용하여, 상대적으로 보유 수량이 많은 멀티턴 대화 데이터에는 낮은 가중치(4%)를 적용하여 과적합을 방지하고, 희소한 도메인 특화 데이터에는 높은 가중치(32%)를 적용하여 학습 효율성을 극대화하였습니다. 또한, Base 모델 학습에 사용되었던 데이터를 Stage-2에서도 함께 사용하여 모델의 망각 현상(Catastrophic Forgetting)을 최소화하도록 설계하였습니다. 1차 학습에 사용한 데이터 별 학습 비중 및 목적은 표 5의 내용과 같습니다.

| 데이터셋 종류

|

학습 비중

|

목적

|

공공기관 특화 RAG 데이터

|

32%

|

|

| 범용 도메인 RAG 데이터

|

32%

|

|

| Instruction Following 데이터

|

16%

|

|

| 멀티턴 대화 데이터

|

4%

|

|

| 기존 SFT 데이터 (Stage-1)

|

16%

|

|

표 5. 1차 학습 데이터 비중 및 사용 목적

4.2. 1차 모델 성능 평가

모델 학습 이후 성능을 검증하기 위해, 본 프로젝트에서는 도메인 적합성과 범용성을 균형 있게 평가할 수 있는 절차를 마련하였습니다. 평가셋은 타겟 도메인(공공·행정·법률) 및 비타겟 도메인(문학·기술과학 등)을 적절히 혼합하여 문서 기반 질의응답(QA), 요약(Summary), 번역(Translation), 멀티턴(Multi-turn)의 4가지로 구성하였습니다.

평가 방법론으로는 대규모 평가셋을 효율적으로 검증하기 위해 G-Eval 기반 자동 평가 방식을 도입하였습니다. G-Eval은 LLM을 활용한 자동화 평가 프레임워크로, 본 프로젝트에서는 정확성, 질문 의도 파악, 일관성, 이해 용이성의 4개 세부 지표를 마련하고 각 항목에 대해 1~5점(INT)의 점수를 매기는 방식을 적용하였습니다. 이를 통해 평가에 소요되는 시간과 노력을 크게 절감함과 동시에, 지표별로 보다 정밀한 분석이 가능하도록 하였습니다.

다만, LLM 기반 자동 평가만으로는 실제 사용성을 온전히 담아내기 어렵다는 점을 고려하여, 일부 평가셋에 대해서는 사람이 직접 정성 평가를 수행하였습니다. 이를 통해 응답의 자연스러움, 사용자 친화성, 실제 업무 적용 가능성과 같은 요소들을 보완적으로 점검하였습니다. G-Eval 평가 결과는 표 6과 같습니다.

| 모델

|

QA

|

Summary

|

Translation

|

Multi-turn

|

| Base 모델

|

4.69

|

4.67

|

3.97

|

3.92

|

| 1차 모델

|

4.82

|

4.72

|

4.07

|

3.96

|

표 6. 1차 모델 성능 (G-Eval 평균)

표 6의 결과를 통해 확인할 수 있듯이, Base 모델이 기본적으로 높은 RAG 성능을 보유하고 있었으나, 도메인 특화 데이터를 추가한 1차 모델에서는 평균적으로 약 1.86%의 성능 개선을 관찰할 수 있었습니다. 특히 번역 태스크에서 2.52%의 성능 개선이 이루어졌으며, 해당 결과는 1차 모델에서 공공·행정·법률 도메인 문서에 대한 이해 및 처리 능력이 강화된 결과로 해석할 수 있습니다.

한편, 정성 평가에서는 G-Eval로는 포착하기 어려운 개선 포인트가 드러났습니다. 예를 들어, 질의응답(QA) 태스크에서는 수리 추론에서의 계산 과정 기술 능력 등이 아직 부족하다는 점을 확인하였습니다. 또한, 한→영 번역 태스크에서는 타겟 언어가 영어임에도 불구하고 일부 사례에서 한글 응답을 출력하는 문제가 발견되었습니다. 이러한 한계는 모델의 실제 활용성 측면에서 반드시 개선이 필요한 영역으로 판단하였으며, 이에 2차 학습에서 해당 문제를 집중적으로 보완할 수 있도록 관련 데이터셋을 확충하여 학습에 반영하였습니다.

4.2. 2차 학습 및 Model Merge: 공공기관 특화 생성 업무 추가 학습 및 모델 성능 고도화

1차 학습을 통해 도메인 특화 RAG 능력을 학습한 이후, 2차 학습에서는 1차 성능의 고도화 및 추가 기능 구현을 목표로 하였습니다. 먼저, 성능 고도화를 위해 1) 싱글턴 및 멀티턴 수리 추론 데이터를 추가 학습하여 수치 계산 및 논리적 추론 능력을 강화하였으며, 1차 모델에서 관찰되었던 미번역 문제를 해결하기 위해 한→영 데이터를 보강하고 안정적인 사용성을 제공할 수 있도록 하였습니다.

다음으로, 기능 구현 측면에서는 1) 회의록 관련 생성 업무(회의록 자동 작성, 후속 업무 계획 수립 지원, 이메일 초안 생성) 및 2) 공공 자료 작성 업무(보도자료·기획안·안내문 초안 작성 및 수정)에 대해 신규로 생성한 데이터를 학습하였습니다. 2차 학습이 완료된 후에는 1, 2차 모델의 장점을 결합하기 위해 모델 가중치 병합(Model Merge) 기법을 적용하였습니다. 이는 각 모델이 가진 특화 능력을 손실 없이 통합하기 위한 기술적 접근법입니다. 2차 모델에 대한 G-Eval 평가 결과는 표 7과 같습니다.

| 모델

|

QA

|

Summary

|

Translation

|

Multi-turn

|

| Base 모델

|

4.69

|

4.67

|

3.97

|

3.92

|

| 1차 모델

|

4.82

|

4.72

|

4.07

|

3.96

|

2차 모델+Model Merge

|

4.86

|

4.8

|

4.25

|

3.9

|

표 7. 2차 모델 성능 (G-Eval 평균)

표 7의 결과와 같이 1차 모델의 미번역 문제를 완벽히 해결하면서 4.44%의 성능 개선이 이루어졌습니다. 질의응답(QA) 태스크에서도 수리 추론 영역이 소폭 향상하여 전반적인 질의응답 성능 개선에도 반영되었습니다. 또한 회의록 작성 및 보도자료 작성의 경우 요약(Summary) 태스크에 포함되기 때문에 요약 성능 개선에 영향을 미쳤습니다. 특정 영역의 성능을 올리기 위한 학습 전략에서 자주 발생하는 트레이드-오프 문제가 멀티턴(Multi-turn) 태스크에서 보였지만, 모델 가중치 병합(Model Merge) 기법을 통해 유의미한 성능 하락을 피할 수 있었습니다.

5. 실무자를 위한 핵심 인사이트

5.1. 기술을 넘어선 전략적 사고의 중요성

좋은 AI 서비스는 단순히 좋은 모델에서 나오는 것이 아니라, 사용자의 니즈를 정확히 이해하고 이를 기술적으로 구현하는 전략에서 나옵니다. 이번 RAG 프로젝트를 성공적으로 완수할 수 있었던 이유 역시, 최신 모델을 사용한 것 보다도 사용자의 요구를 정밀하게 파악하고 이를 데이터 및 모델 설계에 철저하게 반영했기 때문입니다. 실무자에게 필요한 것은 단순 기술을 넘어, 서비스 대상 사용자를 위해 필요한 기능을 반복적으로 설계하고 구체화하는 과정입니다.

5.2. 데이터가 곧 경쟁력이라는 불변의 진리

AI 프로젝트에서 가장 많은 시간과 노력이 투입되는 영역은, 놀랍게도 모델 학습이 아니라 데이터 수집 및 정제 단계입니다. 실제로 이번 프로젝트에서 전체 개발 기간의 약 80%가 양질의 문서 확보 및 학습 데이터셋 설계에 소요되었습니다. 특정 태스크를 수행하는 데 있어 꼭 필요한 문서 또는 데이터는 무엇인지 정의하고, 데이터의 포맷, 길이, 복잡도 등 성능에 영향을 미칠 다양한 요인을 고려하여 데이터를 다양하게 생성하고 꼼꼼하게 정제하는 과정이 필수적입니다. 결국 양이 아니라 질이 성능을 좌우합니다.

5.3. 점진적 발전의 위력

Base 모델에서 시작해 1차, 2차 학습을 거치며 개선해 나간 과정은 ‘완벽한 한 번'보다 '지속적인 개선’이 더 효과적임을 보여줍니다. 각 단계에서 명확한 목표를 설정하고, 성능을 객관적으로 평가한 뒤 다음 단계로 진행하는 방식을 통해 리스크를 최소화하면서도 최종적으로는 더 우수한 결과를 얻을 수 있었습니다. 실무에서는 종종 ‘한 번에 모든 기능을 완벽하게 구현하려는’ 욕심 때문에 프로젝트가 지연되거나 실패하는 경우가 많습니다. 이번 프로젝트 경험은 우선순위 기반의 점진적 접근법이 실용적이고 성공 가능성이 높다는 것을 보여주는 사례입니다.

5.4. 평가 지표의 전략적 설계

AI 모델의 성능을 측정하는 지표는 단순한 수치가 아니라, 프로젝트의 성공 기준을 정의하는 전략적 도구입니다. 이번 프로젝트에서는 LLM 기반의 G-Eval과 정성 평가를 병행하여 정량적 객관성과 실사용성을 균형 있게 검증했습니다. 특히 정확성, 질문 의도 파악, 일관성, 이해 용이성의 네 가지 세부 지표로 나누어 평가함으로써, 모델의 강점과 약점을 정밀하게 파악할 수 있었습니다. 정량적 결과는 개선 방향을 수치로 보여주며, 정성 평가는 실제 사용자 경험에서 드러나는 문제점을 보완적으로 확인할 수 있게 해줍니다. 이처럼 기술적 지표와 사용자 중심 지표를 함께 고려하는 평가 체계를 도입할 필요가 있습니다.

마치며

이번 공공기관 RAG 프로젝트는 KT 믿:음 모델이 실제 서비스 영역에서 실질적인 가치를 창출할 수 있음을 입증한 의미 있는 경험이었습니다. 단순히 모델 성능 개선을 넘어서, 실제 사용자의 니즈와 업무 환경을 깊이 이해하고 이를 기술로 구현하는 전 과정이 얼마나 중요한지 다시 한번 확인할 수 있었습니다. 하지만 이는 시작에 불과합니다.

KT의 AICC 서비스 고도화, 네트워크 이상탐지, 중앙일보와의 AI 서비스 개발 협업 등 다양한 AX 사업 영역에서도 이번 프로젝트에서 축적한 노하우와 방법론을 적극 활용하고 있습니다. 앞으로도 더 많은 영역에서 믿:음 모델이 실질적인 변화를 만들어가는 모습을 보여드릴 수 있도록 하겠습니다. 다음에는 현재 진행중인 사업들을 성공적으로 마무리하여 새로운 인사이트로 돌아오겠습니다.